1. Introducción y revisión de la literatura

El análisis de la desinformación y las fake news ha sido una de las principales tendencias de los últimos años en la investigación científica producida desde diferentes áreas del conocimiento. Desde la victoria de Donald Trump en las elecciones de 2016 y el referéndum del Brexit en el Reino Unido, gran parte de la atención investigadora se ha centrado en descubrir las causas, las características formales, los patrones de producción y propagación y las posibles soluciones de este fenómeno, considerado como uno de los principales problemas en las democracias actuales (Elías, 2021). En los sistemas democráticos liberales, el interés por la desinformación “radica en su presunta capacidad para elevar los niveles de polarización política y, en último término, dañar los principios que fundamentan la convivencia” (Fernández-Roldán, 2021: 60), de ahí la preocupación por este problema desde el ámbito científico, especialmente en el campo de la comunicación.

Tras unos primeros años de optimismo alrededor de las posibilidades democratizadoras y emancipadoras propiciadas por los entornos digitales (Jenkins, 2006; Shirky, 2010), para el impulso de movimientos sociales (Castells, 2012) y el florecimiento del llamado “periodismo ciudadano” (Gillmor, 2004), en el último lustro han proliferado las investigaciones que colocan a los nuevos desarrollos tecnológicos digitales aplicados a la comunicación como una de las principales causas del actual fenómeno de la desinformación. Por ello, gran parte de los estudios se han centrado en cómo frenar la producción y difusión de contenidos falsos en los espacios digitales (Margolin, Hannak y Weber, 2018; Zhang et al., 2019), el análisis de las campañas de desinformación en entornos virtuales (Endsley, 2018) y cómo detectar falsos rumores en las redes sociales (Zubiaga et al., 2018). Este tipo de trabajos abordan también la evaluación de la calidad de las fuentes en estos entornos (Kim, Moravec y Dennis, 2019; Pennycook y Rand, 2019) e, incluso, la idoneidad de censurar contenidos en estas plataformas (Citron, 2018).

La investigación sobre desinformación también ha tenido una mirada amable hacia la tecnología, que sitúa a las herramientas digitales como aliadas en la lucha contra la desinformación. De hecho, un espacio de análisis de creciente importancia durante los últimos años ha sido la efectividad de las soluciones automatizadas y algorítmicas para la detección de noticias falsas (Soe, 2018; Ko et al., 2019). Algunos de estos estudios, como el de Del Vicario et al. (2019), se centran en el análisis de modelos predictivos que ayuden a comprender mejor los patrones de producción de las fake news. Especialmente prolíficos han sido los estudios sobre la detección de los contenidos falsos en las redes, a partir de propuestas de herramientas automáticas de identificación y visualización de noticias falsas (Shu, Mahudeswaran y Liu, 2019). Estas aproximaciones han sido desarrolladas desde dos puntos de vista. Por un lado, existen numerosos estudios que analizan las características de los contenidos para entrenar a los algoritmos en la detección de la desinformación mediante técnicas de aprendizaje automático (machine learning) (Wang et al, 2018), análisis textual (Horne y Adali, 2017), herramientas estilométricas (Potthast et al., 2018) y modelos cuantitativos para la evaluación de la credibilidad del mensaje (Fairbanks et al., 2018). Otros trabajos proponen técnicas de aprendizaje profundo (deep learning) como abordaje para la identificación del contenido malicioso (Riedel et al., 2017; Popat et al., 2018). Por otro, cabe destacar los trabajos centrados en la detección de la desinformación a partir de las características contextuales donde ésta se produce (Tacchini et al., 2017; Volkova et al., 2017) y circula (Wu y Liu, 2018).

También dentro del ámbito tecnológico, los estudios de Fletcher, Schifferes y Thurman (2020) pretenden analizar la efectividad de los algoritmos para realizar evaluaciones automáticas de la credibilidad de las fuentes. En el mismo campo, otras investigaciones se han enfocado en la moderación algorítmica de los contenidos (Gorwa, Binns y Katzenbach, 2020), el uso del big data para detectar la desinformación (Torabi-Asr y Taboada, 2019), la identificación automática de bots en contextos digitales (Beskow y Carley, 2019) y las aplicaciones del blockchain en contra de las informaciones falsas (Chen et al., 2020).

Al margen de las implicaciones tecnológicas de este fenómeno, las estrategias de comunicación para luchar contra la desinformación también han generado un amplio volumen de estudios. Concretamente, estos trabajos han analizado la comunicación efectiva de la ciencia (Rose, 2018), las acciones de contrapropaganda frente a las campañas de desinformación de determinados países (Haigh, Haigh y Kozak, 2018) o cómo contrarrestar los discursos populistas (Bosworth, 2019). Asimismo, gran parte de los trabajos sobre esta problemática se centran en el papel de los medios de comunicación en las crisis desinformativas, sobre todo desde el ámbito del periodismo de verificación (fact-checking). En este campo, se han realizado numerosos estudios sobre la efectividad de estas entidades a la hora de desmontar noticias falsas sobre ciencia (Peter y Koch, 2016), salud (Vraga y Bode, 2017), en contextos electorales (Nyhan et al., 2020) y altamente polarizados (Zollo et al., 2017). La aproximación al estudio del fact-checking también se ha efectuado desde el análisis de sus mecanismos de transparencia para explicar los procesos de verificación a la ciudadanía (Humprecht, 2020), sus efectos sobre la credibilidad de los políticos (Agadjanian et al., 2019) o el uso de las redes sociales y los servicios de mensajería instantánea para desarrollar su labor (Bernal-Triviño y Clares-Gavilan, 2019). Otras investigaciones han puesto en valor el papel del periodismo de investigación colaborativo (Carson y Farhall, 2018), el establecimiento de límites y estándares periodísticos de calidad que contribuyan a diferenciar claramente la información veraz de los contenidos maliciosos y de dudosa calidad (Luengo y García-Marín, 2020), las estrategias a llevar a cabo desde los propios medios para mejorar su credibilidad y la confianza de la ciudadanía (Vos y Thomas, 2018; Pickard, 2020) y la adopción de modelos de comunicación más horizontales y participativos en su relación con las audiencias (Meier, Kraus y Michaeler, 2018).

Como observamos, la desinformación es un objeto de estudio que se ha analizado desde diferentes perspectivas y áreas del saber. El carácter multidimensional del fenómeno (Aparici y García-Marín, 2019) obliga a adoptar abordajes desde diferentes campos al margen del ámbito de la comunicación (y en combinación con éste), tales como las ciencias computacionales, la psicología, la sociología o la educación. Los ciudadanos, los gobiernos en diferentes niveles, los investigadores, las compañías tecnológicas y las organizaciones periodísticas deben, por tanto, unir sus fuerzas para mitigar los contenidos falsos que circulan en los espacios digitales y en los medios tradicionales (Dahlgren, 2018).

En este sentido, la necesidad de implementar programas de alfabetización digital e informacional a partir de pedagogías críticas (Higdon, 2020) tiene una presencia relevante en la investigación sobre esta problemática. En este ámbito, destacan las aportaciones de Roozenbeek y Van der Linden (2019) y Roozenbeek et al. (2020) sobre la efectividad de la estrategia de la inoculación para poner a los ciudadanos en la piel de los creadores de desinformación a fin de detectarla. Desde una perspectiva más general, otras investigaciones han demostrado la eficiencia que los proyectos de alfabetización informacional tienen en la lucha contra los contenidos maliciosos (Amazeen y Bucy, 2019), en redes sociales como Twitter (Vraga, Bode y Tully, 2020) y en países concretos, como Estados Unidos o India (Guess et al., 2020). Khan y Idris (2019) han demostrado la correlación entre la educación informacional de la ciudadanía y la capacidad de identificar noticias falsas, mientras que otros trabajos como los de Gómez-Suárez (2017) y Buckingham (2019) ponen de relieve la importancia del pensamiento crítico en cualquier proyecto de educación mediática contra los contenidos maliciosos. Asimismo, el estallido de informaciones engañosas e inventadas sobre la Covid-19 desde comienzos de 2020 ha provocado que no pocas voces defiendan la implementación de acciones para potenciar la educación científica de los ciudadanos (Hughes, 2019; López-Borrull, 2020; Sharon y Baram-Tsabari, 2020).

Durante los últimos años, también han sido ciertamente frecuentes los trabajos sobre los marcos regulatorios que determinados países han impuesto a fin de minimizar el impacto de las fake news, especialmente en los medios digitales (Baade, 2018; Perl, Howlett y Ramesh, 2018). De forma más modesta en cuanto al volumen de publicaciones, otros estudios se han interesado por el papel de las bibliotecas como curadores de contenido (Walter et al., 2020), las acciones para recuperar la confianza y credibilidad de las instituciones políticas (Hunt, Wang y Zhuang, 2020), sociales (Bjola y Papadakis, 2020) y educativas, y las implicaciones éticas en la lucha contra la desinformación (Bjola, 2018).

Esta elevada producción académica generada en el último lustro ha favorecido la publicación de diversas revisiones de la literatura científica centrada en el estudio de la desinformación. Algunos trabajos de este tipo, como los de Tandoc (2019) y Jankowski (2018), se han realizado de forma no sistemática. Las revisiones sistemáticas -poco numerosas- se caracterizan por su amplia variedad de temas y enfoques. Destacan aquellas centradas en los estudios específicos sobre las fake news (Ha, Andreu-Pérez y Ray, 2019), las investigaciones sobre el periodismo de verificación (Chan et al., 2017; Nieminen y Rapeli, 2019), los análisis de la desinformación en los social media (Pierri y Ceri, 2019), las revisiones falsas de productos en el marco del comercio electrónico (Wu et al., 2020) y, por último, las definiciones para los diferentes tipos de desinformación con el fin de elaborar una clasificación unificada de los desórdenes informativos (Kapantai et al., 2020).

En sintonía con estos trabajos, nuestra investigación consiste en una revisión sistemática de la literatura (RSL) acerca del fenómeno de la desinformación, desde una perspectiva general y con una mirada cuantitativa. Sin embargo, como se explicará en el siguiente apartado, nuestro estudio presenta claras diferencias con los trabajos de esta naturaleza realizados hasta la fecha. Por un lado, no se centra en un aspecto exclusivo de la problemática, sino que la aborda desde un punto de vista multidimensional y multidisciplinar, integrando las diferentes miradas y áreas del conocimiento desde las que se han afrontado estos estudios. Además, la muestra incluye un volumen de trabajos analizados (n=605) muy superior al número de investigaciones incluidas en las revisiones anteriormente citadas. Por último, integra un análisis estadístico del impacto de estas investigaciones (medido con el número de citas recibidas y normalizado con respecto al año de publicación de los trabajos) a partir del cruce de diferentes variables: temáticas, áreas de conocimiento, tipos de trabajo y país de procedencia.

2. Preguntas de investigación y método

Nuestro trabajo, de tipo eminentemente cuantitativo, pretende dar respuesta a las siguientes cuestiones:

- P1. ¿Cuáles son los temas investigados en el campo de la desinformación en el periodo 2016-2020? ¿Cuáles tienen más impacto (número de citas recibidas normalizado con respecto al año de publicación)? ¿El tema investigado es una variable determinante en el impacto?

- P2. ¿Cuál es la frecuencia de estos estudios por año de publicación? ¿Qué temas han sido más publicados cada año?

- P3. ¿Cuáles son las áreas del conocimiento que realizan estudios sobre desinformación? ¿Cuáles tienen más impacto? ¿El área de conocimiento es una variable determinante en el impacto de los trabajos?

- P4. ¿Cuáles son los tipos de trabajo y las metodologías de estos estudios? ¿Qué tipos presentan mayor impacto? ¿Es el tipo de trabajo una variable determinante en su impacto?

- P5. ¿Cuáles son los países desde donde se realizan estos estudios? ¿Cuáles acumulan mayor impacto? ¿El país de procedencia del estudio es una variable determinante en su impacto?

- P6. ¿Cuáles son los estudios de caso más frecuentes? ¿La realización de estudios de caso es una variable determinante en el impacto?

- P7. ¿Cuáles son los tipos de trabajo y los métodos de investigación utilizados por los diferentes países?

- P8. ¿Cuáles son los tipos de trabajos / metodologías utilizadas según la temática de estos estudios?

Para responder estas cuestiones, se llevó a cabo un trabajo de revisión sistemática de la literatura bajo los principios propuestos por Kitchenham (2004), caracterizados por la transparencia y sistematización en cada una de sus fases (Codina, 2020). Este abordaje permite conocer en profundidad, evaluar e interpretar el trabajo científico realizado sobre un objeto de estudio determinado en un periodo de tiempo previamente establecido (Ramírez-Montoya y García-Peñalvo, 2018).

Nuestro proceso metodológico se fundamentó en las aportaciones de Higgins et al. (2019), Brereton et al. (2007) y Centre for Reviews and Dissemination de York University (2009), que dividen los estudios con revisiones sistemáticas en tres etapas: (1) planificación del trabajo a partir de la definición previa de un conjunto de preguntas de investigación, (2) realización de la búsqueda documental y creación de la base de datos definitiva tras la aplicación de un conjunto de criterios de inclusión y exclusión, y (3) elaboración del informe de resultados para dar respuesta a las cuestiones previamente establecidas.

Para la identificación de artículos a analizar, centramos nuestro estudio en la base de datos Web of Science (WoS). Al igual que en otros trabajos anteriores similares al nuestro, como el de López-García et al. (2019), utilizamos exclusivamente esta base de datos por ser la de mayor relevancia en el ámbito científico y porque se pretende recoger las investigaciones publicadas en las revistas de mayor impacto y visibilidad a nivel internacional. Para ejecutar la primera fase de recopilación de publicaciones, se adoptaron los siguientes criterios de inclusión:

- Estudios publicados en la base de datos Social Sciences Citation Index (SSCI) de WoS.

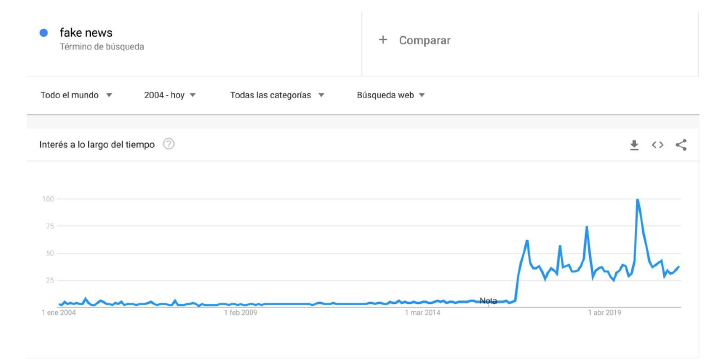

- Periodo de publicación: 2016-2020. Se elige el 2016 como punto de partida por ser el año de eclosión de este fenómeno tal como lo conocemos en nuestros días (Aparici y García-Marín, 2019), con la victoria de Donald Trump en las elecciones estadounidenses y el referéndum del Brexit en el Reino Unido. En 2016, el término post-truth (posverdad) fue elegido palabra del año por el diccionario Oxford. Tras la victoria de Trump a finales de 2016, el uso del término fake news “empezó a generalizarse en los medios de comunicación y, por extensión, en la sociedad” (Rodríguez-Fernández, 2021: 48), como muestra el gráfico de evolución de las búsquedas de este término en Google entre enero de 2004 y mayo de 2021 (figura 1). El crecimiento de las búsquedas comenzó a ser significativo desde noviembre de 2016.

- Trabajos que abordan el fenómeno de la desinformación desde cualquiera de sus vertientes y desde cualquier campo del conocimiento (comunicación, psicología, sociología, educación, ciencias políticas, etc.).

- Inclusión en el título, resumen o palabras clave de al menos uno de los siguientes términos: “disinformation”, “fake news”, “post-truth” o “misinformation”. Para ello, se realizaron búsquedas avanzadas mediante operadores booleanos: “disinformation” OR “fake news” OR “post-truth” OR “misinformation”.

- Quedaron incluidos no solo los trabajos empíricos, sino también los estudios de revisión teórica y los ensayos publicados por revistas científicas.

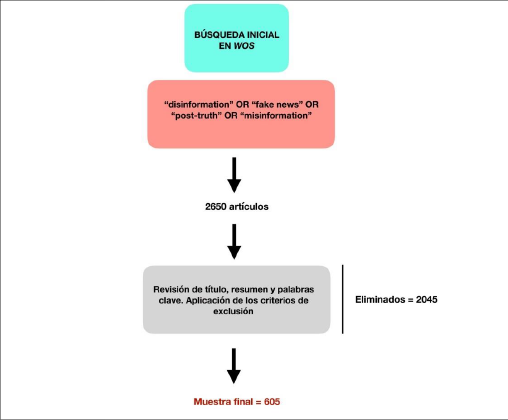

La recopilación inicial de artículos tuvo lugar el 7 de diciembre de 2020. Se recogieron 2650 publicaciones (figura 2), que fueron analizadas mediante revisión exhaustiva del título, resumen y palabras clave. Sobre este primer corpus de publicaciones, se llevó a cabo un trabajo de depuración mediante la aplicación de dos criterios de exclusión:

- Se eliminaron los artículos editoriales de presentación de monográficos y números especiales.

- Se excluyeron los trabajos no relacionados con el objeto de estudio, a pesar de incluir algunos de los términos de búsqueda. En este sentido, la búsqueda con el término “misinformation” resultó especialmente problemática, porque bajo este concepto se etiquetan trabajos sobre cómo se establece la comunicación por parte de determinados colectivos (personas con discapacidad, por ejemplo) y entre actuantes no humanos (transmisión de información entre máquinas y/o dispositivos tecnológicos digitales), aspectos que nada tienen que ver con nuestro objeto de estudio. También se descartaron numerosos trabajos con el término “post-truth” porque esta palabra es utilizada en muchos artículos para caracterizar la época actual pero, en realidad, sus temáticas no se sitúan en el ámbito de la desinformación.

Tras esta fase de revisión, la muestra definitiva quedó fijada en 605 trabajos. A continuación, se identificaron las categorías de codificación (señaladas en la tabla 1) para cada una de las siete variables presentes en nuestras preguntas de investigación: (1) tema de los trabajos, (2) año de publicación, (3) áreas de estudio, (4) tipos de trabajo / metodologías, (5) país de origen de la investigación, (6) estudios de caso y (7) impacto normalizado. En el caso del país de origen, se tomó como referencia la nacionalidad de la institución del investigador principal del trabajo. Los datos extraídos fueron analizados mediante estadística descriptiva e inferencial con el paquete estadístico SPSS v.26.

Para medir el impacto de los trabajos, no se utilizó el número absoluto de citas recibidas a fin de evitar distorsiones derivadas del año de publicación. En su lugar, se relativizó el número de citas de cada artículo con respecto al promedio de citas de cada uno de los años de publicación (2016, 2017, 2018, 2019 y 2020). Este promedio de citas anuales se obtuvo de la muestra analizada. Por tanto, el impacto normalizado de cada artículo es el resultado de dividir su número de citas entre el promedio de citas de su año de publicación. Se decidió normalizar el impacto con este procedimiento en lugar de utilizar el dato de citas mundiales del área de conocimiento específico debido a la falta de disponibilidad de tales datos correspondientes a los años 2019 y 2020 (ver tablas de citas mundiales actualizadas en este enlace: https://cutt.ly/3Ejykus).

Figura 1. Evolución de las búsquedas del término “fake news” en Google entre enero de 2004 y mayo de 2021

Fuente: Google Trends

Figura 2. Proceso de revisión sistemática seguido en este trabajo

Fuente: elaboración propia

Tabla 1. Relación de cada variable con sus categorías de codificación

|

Variable |

Categorías de codificación |

|

Tema |

General Soluciones y estrategias Sesgos cognitivos e ideológicos Producción de la desinformación Consecuencias / impacto Propagación del contenido desinformativo Causas de la desinformación Definiciones de conceptos clave Percepciones sobre la desinformación Papel del periodismo Emociones y desinformación Deepfakes Negacionismo Ciberseguridad |

|

Año |

2016 2017 2018 2019 2020 |

|

Áreas de conocimiento |

Comunicación (ningún área relacionada) Psicología Política Análisis de RRSS Salud Educación Ciencia Sociología Filosofía Economía |

|

Tipo de trabajo / metodologías |

Cuantitativo Experimento Cualitativo Mixto (cuantitativo-cualitativo) Revisión teórica Ensayo |

|

País |

Se tuvo en cuenta el país de afiliación del investigador de referencia firmante del artículo |

|

Estudio de caso |

Sí / No. Indicar el caso |

|

Impacto normalizado |

Número de citas recibidas por el artículo con fecha 07/12/2020, dividido entre el promedio de citas del año del artículo (obtenido de la muestra). |

Fuente: elaboración propia

Para ejecutar los cálculos estadísticos inferenciales y, de esta forma, comprobar la existencia de diferencias significativas en las variables del estudio, procedimos previamente a calcular el índice de normalidad de la muestra en cuanto al impacto normalizado. Esta operación es necesaria para elegir la aplicación de pruebas paramétricas o no paramétricas en los cálculos estadísticos. Se llevaron a cabo pruebas de Kolgomorov-Smirnov que determinaron la ausencia de distribuciones normales en la variable relativa al impacto normalizado de los trabajos (p < .01). Por ello, se decidió utilizar pruebas no paramétricas de Kruskal-Wallis y U de Mann-Whitney, a fin de descubrir diferencias relevantes en el impacto en función de las diferentes categorías de las variables y, en su caso, realizar las comparaciones múltiples entre tales categorías.

3. Resultados

Dado el volumen de cuestiones planteadas en nuestro estudio y con el objetivo de facilitar la lectura de este apartado, se presentan los resultados introduciendo primero cada una de las preguntas de nuestra investigación.

P1. ¿Cuáles son los temas investigados en el campo de la desinformación en el periodo 2016-2020? ¿Cuáles tienen más impacto (número de citas recibidas normalizado con respecto al año de publicación)? ¿El tema investigado es una variable determinante en el impacto?

Los estudios más prevalentes son aquellos que analizan las posibles soluciones y estrategias para afrontar el problema de la desinformación (n=144; 23,80%) (tabla 2). Estas investigaciones se centran en un total de 12 subcategorías temáticas: (1) soluciones relacionadas con las plataformas y redes sociales, (2) estrategias de comunicación, (3) el papel de los medios, (4) políticas contra la desinformación, (5) soluciones tecnológicas, algorítmicas y automatizadas, (6) la educación contra las noticias falsas, (7) el papel de las bibliotecas, (8) la recuperación de la confianza en las instituciones, (9) el papel del arte contra la desinformación, (10) implicaciones éticas en la lucha contra las fake news, (11) la verificación y evaluación de fuentes informativas y (12) meta-análisis de las soluciones propuestas. En el apartado de anexos, se recogen todas las soluciones y estrategias frente a la desinformación abordadas por los estudios analizados.

Tabla 2. Promedio y desviación típica del número del impacto normalizado por temas

|

Tema |

Frecuencias |

Impacto normalizado |

|

|

Promedio |

DT |

||

|

Soluciones y estrategias |

144 (23,80%) |

0,84 |

0,92 |

|

Sesgos cognitivos |

119 (19,67%) |

0,96 |

1,41 |

|

Producción |

84 (13,88%) |

0,69 |

0,78 |

|

Consecuencias, impacto |

57 (9,42%) |

1,17 |

1,91 |

|

Propagación |

47 (7,77%) |

2,29 |

5,38 |

|

Causas |

46 (7,60%) |

0,90 |

0,99 |

|

General |

34 (5,62%) |

0,95 |

1,25 |

|

Definiciones |

22 (3,63%) |

1,33 |

2,24 |

|

Percepciones (sobre la desinformación) |

22 (3,63%) |

0,73 |

0,73 |

|

Papel del periodismo |

11 (1,81%) |

0,38 |

0,19 |

|

Emociones |

7 (1,16%) |

0,45 |

0,31 |

|

Negacionismo |

5 (0,82%) |

0,65 |

0,50 |

|

Deepfakes |

5 (0,82%) |

0,91 |

0,48 |

|

Ciberseguridad |

2 (0,33%) |

0,43 |

0,41 |

|

p valor (χ2) |

< .00* |

||

|

p valor (Kruskal-Wallis) |

.19** |

||

*Se observan diferencias muy significativas cuando p < .01.

**Se observan diferencias significativas cuando p < .05.

Fuente: elaboración propia

Tras las soluciones, los estudios más frecuentes son aquellos relacionados con los sesgos cognitivos e ideológicos (n=119; 19,67%). Los análisis sobre los mecanismos de producción de la desinformación alcanzan el 13,88% de los estudios (n=84), mientras que los relativos a las repercusiones o las consecuencias de esta problemática suponen el 9,42% (n=57). Las pruebas de chi cuadrado determinan diferencias muy significativas en las frecuencias de esta variable [χ2(13, N = 605) = 595.41, p < .00].

Los trabajos con mayor impacto son aquellos que abordan los patrones de propagación de los contenidos falsos (M=2,29; DT=5,38). Tras ellos, se sitúan los estudios que analizan desde un punto de vista teórico las definiciones de los conceptos clave relacionados con esta problemática (fake news, desinformación, posverdad, desórdenes informativos, etc.), con un impacto medio de 1,33 y una desviación típica de 2,24. Los estudios sobre las consecuencias o las repercusiones de la desinformación se sitúan como la tercera temática más citada (M=1,17; DT=1,91). Las pruebas de Kruskal-Wallis observaron que la temática de los trabajos no constituye una variable relevante en su impacto [H(13) = 17.12, p = .19].

P2. ¿Cuál es la frecuencia de estos estudios por año de publicación? ¿Qué temas han sido más publicados cada año?

Los estudios sobre desinformación publicados en WoS han ido en aumento en el periodo 2016-2020. Se han recogido 37 estudios publicados en 2016 (6,11%), 84 en 2017 (13,88%), 151 en 2018 (24,95%), 198 en 2019 (32,72%) y 135 en 2020 (22,31%). Entre 2016 y 2020, las investigaciones publicadas sobre este objeto de estudio se multiplicaron por cinco.

La tabla 3 recoge las temáticas por año incluidas en nuestra muestra. Destacan dos tendencias opuestas. Por un lado, el porcentaje de estudios sobre soluciones y estrategias contra la desinformación crecieron de forma notable durante todo el periodo. Esta temática representaba el 8,10% de los estudios publicados en 2016, mientras que en 2020 este aspecto fue abordado en el 28,89% de los trabajos de ese año. En un sentido inverso, ha descendido de forma relevante el porcentaje de investigaciones sobre sesgos cognitivos, que representaban el 35,13% de los trabajos de 2016 y solo el 17,03% de las investigaciones de 2020. De este dato inferimos que antes de la proliferación de estudios sobre desinformación a partir de 2017, ya existía un notable interés sobre los sesgos psicológicos y la credibilidad de la información.

Tabla 3. Número de trabajos publicados por temáticas durante el periodo 2016-2020. Las frecuencias relativas se refieren al porcentaje de trabajos publicados en esa temática dentro del año

|

Tema |

2016 |

2017 |

2018 |

2019 |

2020 |

|

Causas |

2 (5,40%) |

9 (10,71%) |

14 (9,27%) |

17 (8,58%) |

4 (2,96%) |

|

Consecuencias, impacto |

2 (5,40%) |

6 (7,14%) |

15 (9,93%) |

16 (8,08%) |

18 (13,33%) |

|

Definiciones |

0 (0,00%) |

5 (5,95%) |

10 (6,62%) |

5 (2,52%) |

2 (1,48%) |

|

Propagación |

4 (10,81%) |

7 (8,33%) |

9 (5,96%) |

16 (8,08%) |

11 (8,14%) |

|

Sesgos cognitivos |

13 (35,13%) |

24 (28,57%) |

23 (15,23%) |

36 (18,18%) |

23 (17,03%) |

|

Soluciones y estrategias |

3 (8,10%) |

13 (15,47%) |

36 (23,84%) |

53 (26,76%) |

39 (28,89%) |

|

General |

0 (0,00%) |

5 (5,95%) |

9 (5,96%) |

14 (7,07%) |

6 (4,44%) |

|

Producción |

6 (16,21%) |

7 (8,33%) |

23 (15,23%) |

24 (12,72%) |

24 (17,78%) |

|

Percepciones |

3 (8,10%) |

4 (4,76%) |

6 (3,97%) |

7 (3,53%) |

2 (1,48%) |

|

Negacionismo |

0 (0,00%) |

1 (1,19%) |

1 (0,66%) |

3 (1,51%) |

0 (0,00%) |

|

Papel del periodismo |

1 (2,70%) |

1 (1,19%) |

3 (1,98%) |

3 (1,51%) |

3 (2,22%) |

|

Emociones |

3 (8,10%) |

2 (2,38%) |

1 (0,66%) |

0 (0,00%) |

1 (0,74%) |

|

Deepfakes |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

3 (1,51%) |

2 (1,48%) |

|

Ciberseguridad |

0 (0,00%) |

0 (0,00%) |

1 (0,66%) |

1 (0,50%) |

0 (0,00%) |

|

Total |

37 |

84 |

151 |

198 |

135 |

Fuente: elaboración propia

P3. ¿Cuáles son las áreas del conocimiento que realizan estudios sobre desinformación? ¿Cuáles tienen más impacto? ¿El área de conocimiento es una variable determinante en el impacto de los trabajos?

Se observan diferencias muy pronunciadas en el número de estudios por área de conocimiento [χ2(9, N = 605) = 310.62, p < .00]. El campo de la psicología (los estudios sobre sesgos cognitivos, especialmente) es el área desde el que se realizan mayor número de investigaciones (n=131; 21,65%) (tabla 4). Los trabajos desde las ciencias políticas (n=119; 19,67%) y los estudios sobre redes sociales (n=112; 18,51%) han sido también ciertamente prominentes. Tras ellos, se sitúan los artículos sobre salud (n=71; 11,73%), sin duda como consecuencia de la proliferación de investigaciones que analizan la desinformación derivada de la pandemia por Covid-19, asunto muy investigado durante todo el año 2020.

Precisamente, los trabajos que proceden del campo de la salud son los que presentan mayor impacto (M=1,17; DT=1,39). También es relevante el impacto de los estudios sobre desinformación en redes sociales y plataformas digitales (M=1,13; DT=3,33) y los relativos al ámbito de la política (M=1,10; DT=1,90). Los artículos ubicados exclusivamente en el ámbito de la comunicación (sin ningún área relacionada, por tanto) alcanzan un impacto medio de 1,05 (DT=1,66). Las pruebas no paramétricas ejecutadas determinan que el campo de estudio no es un factor relevante en el impacto de estos trabajos [H(9) = 13.60, p = .13].

Tabla 4. Promedio y desviación típica del impacto normalizado por áreas de conocimiento

|

Áreas |

Frecuencias |

Impacto normalizado |

|

|

Promedio |

DT |

||

|

Psicología |

131 (21,65%) |

0,92 |

1,36 |

|

Política |

119 (19,67%) |

1,10 |

1,90 |

|

Redes |

112 (18,51%) |

1,13 |

3,33 |

|

Salud |

71 (11,73%) |

1,17 |

1,39 |

|

Comunicación (ningún área relacionada) |

56 (9,25%) |

1,05 |

1,66 |

|

Educación |

38 (6,28%) |

0,70 |

0,59 |

|

Ciencia |

32 (5,29%) |

1,04 |

1,12 |

|

Sociología |

26 (4,29%) |

0,52 |

0,41 |

|

Filosofía |

12 (1,98%) |

0,42 |

0,30 |

|

Economía |

8 (1,32%) |

0,80 |

0,44 |

|

p valor (χ2) |

< .00* |

||

|

p valor (Kruskal-Wallis) |

.13** |

||

*Se observan diferencias muy significativas cuando p < .01.

**Se observan diferencias significativas cuando p < .05.

Fuente: elaboración propia

P4. ¿Cuáles son los tipos de trabajo y las metodologías de estos estudios? ¿Qué tipos presentan mayor impacto? ¿Es el tipo de trabajo una variable determinante en su impacto?

El ensayo es el tipo de trabajo más frecuente (n=168; 27,77%), seguido de los estudios cuantitativos (n=159; 26,28%) y los experimentales (n=135; 22,31%) (tabla 5). Nótese que los estudios experimentales son también de tipo cuantitativo, por lo que las metodologías cuantitativas alcanzan casi la mitad de la muestra analizada (48,59%). Es mucho menos frecuente la publicación de estudios cualitativos (n=55; 9,09%) y los realizados con metodologías mixtas (articulación de métodos cualitativos y cuantitativos) (n=48; 7,93%) . Como sucedía en el caso de las temáticas y las áreas de conocimiento, existen diferencias muy significativas en las frecuencias de esta variable [χ2(5, N = 605) = 175.09, p < .00].

Los trabajos de tipo cuantitativo no experimental reciben un número mayor de citas relativas y, por tanto, logran mayor impacto (M=1,42; DT=3,18). Tras éstos, se sitúan los estudios de revisión de la literatura (M=1,24; DT=1,90), que presentan un elevado impacto a pesar de ser el tipo de trabajo menos frecuentemente publicado. Los artículos con menor impacto son los de tipo cualitativo (M=0,75; DT=0,94) y los ensayísticos (M=0,76; DT=0,86). Se observa que el tipo de trabajo o metodología utilizada constituye un factor determinante en su impacto [H(5) = 15.78, p < .00]. La tabla 6 recoge los tipos de trabajo concretos donde las diferencias en el impacto resultan significativas (p < .05) o muy significativas (p < .01).

Tabla 5. Promedio y desviación típica del impacto normalizado por tipo de trabajo

|

Tipo de trabajo / metodología |

Frecuencias |

Impacto normalizado |

|

|

Promedio |

DT |

||

|

Ensayo |

168 (27,77%) |

0,76 |

0,86 |

|

Cuantitativo |

159 (26,28%) |

1,42 |

3,18 |

|

Experimento |

135 (22,31%) |

0,84 |

1,06 |

|

Cualitativo |

55 (9,09%) |

0,75 |

0,94 |

|

Mixto (cuantitativo-cualitativo) |

48 (7,93%) |

0,93 |

1,83 |

|

Revisión |

40 (6,61%) |

1,24 |

1,90 |

|

p valor (χ2) |

< .00* |

||

|

p valor (Kruskal-Wallis) |

< .00* |

||

*Se observan diferencias muy significativas cuando p < .01.

Fuente: elaboración propia

Tabla 6. Comparativas múltiples mediante prueba de Kruskal-Walis sobre el impacto normalizado para cada uno de los tipos de trabajo / metodologías empleadas

|

Tipos / métodos comparados |

p valor (Kruskal-Wallis |

|

Mixto-Cuantitativo |

.031* |

|

Cualitativo-Cuantitativo |

.008** |

|

Experimento-Cuantitativo |

.007** |

|

Ensayo-Cuantitativo |

.002** |

*Se observan diferencias significativas cuando p < .05.

**Se observan diferencias muy significativas cuando p < .01.

Fuente: elaboración propia

P5. ¿Cuáles son los países desde donde se realizan estos estudios? ¿Cuáles acumulan mayor impacto? ¿El país de procedencia del estudio es una variable determinante en su impacto?

Como era de esperar, los trabajos procedentes del mundo anglosajón son mayoritarios en este ámbito, siendo Estados Unidos el país que aglutina una abrumadora mayoría de estas investigaciones. Los cuatro países con mayor número de estudios son de habla inglesa: Estados Unidos (n=272; 44,95%), Reino Unido (n=74; 12,23%), Canadá (n=34; 5,61%) y Australia (27; 4,46%). Tras ellos, se sitúan Alemania (n=27; 4,46%) y España, con un total de 25 trabajos (4,13%). En la tabla 7 se recogen los datos de los países que registran más de 10 estudios publicados.

Entre las naciones con más de 10 investigaciones publicadas, el país con mayor impacto es Italia, con un promedio de 1,51. No obstante, el elevado valor de su desviación típica en esta variable (DT= 2,56), nos advierte de la existencia de una distribución muy desigual en el número de citas, por lo que este país publica ciertos trabajos con mucho impacto y otros con una relevancia muy menor. Tras Italia, se sitúan Estados Unidos (M=1,23; DT=2,56), Canadá (M=1,04; DT=1,23), Reino Unido (M=0,80; DT=0,99) y Australia (M=0,80; DT=0,64). Les siguen Alemania (M=0,75; DT=0,66) y Holanda (M=0,73; DT=0,90).

Existen diferencias muy notables en el número de trabajos publicados por países [χ2(47, N = 605) = 5937.99, p < .00]. Por contra, el país de procedencia de los estudios no es una variable determinante en su impacto [H(47) = 54.53, p = .21].

Tabla 7. Promedio y desviación típica del impacto normalizado por país

|

País |

Frecuencias |

Impacto normalizado |

|

|

Promedio |

DT |

||

|

Estados Unidos |

272 (44,95%) |

1,23 |

2,56 |

|

Reino Unido |

74 (12,23%) |

0,80 |

0,99 |

|

Canadá |

34 (5,61%) |

1,04 |

1,23 |

|

Australia |

27 (4,46%) |

0,80 |

0,64 |

|

Alemania |

27 (4,46%) |

0,75 |

0,66 |

|

España |

25 (4,13%) |

0,50 |

0,58 |

|

Italia |

18 (2,97%) |

1,51 |

2,56 |

|

China |

12 (1,98%) |

0,44 |

0,22 |

|

Holanda |

11 (1,81%) |

0,73 |

0,90 |

|

p valor (χ2) |

< .00* |

||

|

p valor (Kruskal-Wallis) |

.21** |

||

*Se observan diferencias muy significativas cuando p < .01.

**Se observan diferencias significativas cuando p < .05.

Fuente: elaboración propia

P6. ¿Cuáles son los estudios de caso más frecuentes? ¿La realización de estudios de caso es una variable determinante en el impacto?

En nuestra muestra se detectaron 120 estudios de caso, que representan el 19,83% del total. La desinformación vinculada a la Covid-19 es el caso más analizado (n=26; 21,66%), seguido de las elecciones estadounidenses de 2016 (n=15; 12,505), el mandato de Donald Trump al frente de la Casa Blanca (10,83%) y las injerencias rusas en la política estadounidense (n=8; 6,67%). Se percibe, por tanto, un evidente sesgo geográfico en los casos más analizados, puesto que todos ellos (a excepción de la pandemia por Covid-19) se vinculan con procesos políticos ligados a Estados Unidos, país líder en producción científica en el campo de la desinformación. Los datos completos sobre las frecuencias de los estudios de caso analizados se encuentran disponibles en el siguiente enlace: https://cutt.ly/Bb9Ms5d

Los estudios de caso tienen un mayor impacto (M=1,35; DT= 2,01) que los artículos que no incluyen trabajos de este tipo (M=0,91; DT=1,91). Las pruebas no paramétricas (en este caso, la U de Mann-Whitney ya que comparamos solo dos grupos) detectan diferencias muy significativas en el impacto normalizado de ambos tipos de estudio (z = -2.895, p = .004).

P7. ¿Cuáles son los tipos de trabajo y los métodos de investigación utilizados por los diferentes países?

Se observan diferencias muy relevantes en los tipos de trabajos publicados en función de los países (tabla 8). Destacamos a continuación algunas de las cuestiones más llamativas. En primer lugar, es relevante el elevado porcentaje de estudios cuantitativos realizados en Estados Unidos (57,35% de los trabajos que proceden de este país). El 29,41 de las investigaciones de este país son estudios experimentales. En general, se observa una mayor tendencia en el ámbito anglosajón hacia la publicación cuantitativa y experimental, que alcanza el 37,82% de los estudios en el Reino Unido, el 35,29% en Canadá y el 40,74% en Australia.

Asimismo, es reseñable el elevadísimo porcentaje de trabajos cuantitativos no experimentales realizados en Italia (72,22%). La tendencia de este país hacia la publicación de estudios con mirada cuantitativa puede explicar el elevado impacto medio de los manuscritos publicados desde esta nación; dado que los estudios cuantitativos son los que mayor número de citas relativas reciben. Por contra, más de la mitad de los estudios publicados desde Alemania (51,85%) son ensayos, mientras que España es el país con mayor porcentaje de estudios con aproximaciones mixtas (36,00%). En términos comparados, en España se publican muchos menos estudios de tipo cuantitativo (solo el 16,00%, un 8,00% de los trabajos son experimentales y otro 8,00% cuantitativos no experimentales). Resulta llamativo que los tipos de trabajo que presentan mayor impacto (cuantitativos y revisiones teóricas) son los menos publicados desde España.

Tabla 8. Tipos de trabajo por país. Las frecuencias relativas se refieren al tipo de trabajo publicado por cada país

|

País |

Cuant. |

Cualit. |

Exper. |

Mix. |

Rev. |

Ens. |

|

Estados Unidos n=272 |

76 (27,94%) |

15 (5,51%) |

80 (29,41%) |

11 (4,04%) |

14 (5,88%) |

74 (27,20%) |

|

Reino Unido n=74 |

14 (18,91%) |

10 (13,51%) |

14 (18,91%) |

6 (8,11%) |

2 (2,70%) |

28 (37,83%) |

|

Canadá n=34 |

9 (26,47%) |

1 (2,94%) |

3 (8,82%) |

3 (8,82%) |

2 (5,88%) |

16 (47,05%) |

|

Australia n=27 |

7 (25,92%) |

5 (18,51%) |

4 (14,81%) |

2 (7,40%) |

1 (3,70%) |

8 (29,63%) |

|

Alemania n=27 |

2 (7,40%) |

3 (11,11%) |

6 (22,22%) |

1 (3,70%) |

1 (3,70%) |

14 (51,85%) |

|

España n=25 |

2 (8,00%) |

5 (20,00%) |

2 (8,00%) |

9 (36,00%) |

1 (4,00%) |

6 (24,00%) |

|

Italia n=18 |

13 (72,22%) |

1 (5,55%) |

1 (5,55%) |

0 (0,00%) |

2 (11,11%) |

1 (5,55%) |

|

China n=12 |

7 (58,33%) |

0 (0,00%) |

1 (8,33%) |

1 (8,33%) |

1 (8,33%) |

2 (16,66%) |

|

Holanda n=11 |

1 (9,09%) |

2 (18,18%) |

4 (36,36%) |

1 (9,09%) |

2 (18,18%) |

1 (9,09%) |

Fuente: elaboración propia

P8. ¿Cuáles son los tipos de trabajo y las metodologías utilizadas según la temática de estos estudios?

Por último, nuestros resultados señalan que los estudios sobre las soluciones a la problemática de la desinformación se abordan principalmente desde trabajos ensayísticos (pertenecen a este tipo el 33,33% de las publicaciones sobre este tema), y a través de métodos experimentales (25,00%) (tabla 9). Las causas, las consecuencias de la desinformación y las definiciones sobre conceptos clave se analizan mayoritariamente con ensayos (47,82%; 35,08% y 81,81% respectivamente). Los estudios sobre sesgos se ejecutan, fundamentalmente, con diseños experimentales (65,54%), mientras que los patrones de propagación de los contenidos falsos se abordan con investigaciones cuantitativas no experimentales (65,96%). También es reseñable el porcentaje de este tipo de metodologías cuantitativas utilizadas para analizar la producción de los contenidos desinformativos (40,47%).

Tabla 9. Temáticas abordadas por tipo de trabajo. Las frecuencias relativas se refieren a la temática para cada tipo de trabajo

|

Tema |

Cuant. |

Cualit. |

Exper. |

Mix. |

Rev. |

Ens. |

|

Causas n=46 |

13 (28,26%) |

4 (8,69%) |

1 (2,17%) |

2 (4,34%) |

4 (8,69%) |

22 (47,82%) |

|

Consecuencias, impacto n=57 |

16 (28,07%) |

8 (14,03%) |

7 (12,28%) |

3 (5,26%) |

3 (5,26%) |

20 (35,08%) |

|

Definiciones n=22 |

1 (4,54%) |

0 (0,00%) |

0 (0,00%) |

1 (4,54%) |

2 (9,09%) |

18 (81,81%) |

|

Propagación n=47 |

31 (65,95%) |

3 (6,38%) |

6 (12,76%) |

3 (6,38%) |

2 (4,25%) |

2 (4,25%) |

|

Sesgos cognitivos n=119 |

25 (21,01%) |

0 (0,00%) |

78 (65,54%) |

3 (2,52%) |

6 (5,04%) |

7 (5,88%) |

|

Soluciones y estrategias n=144 |

25 (17,36%) |

15 (10,415%) |

36 (25,00%) |

7 (4,86%) |

13 (9,02%) |

48 (33,33%) |

|

General n=34 |

1 (2,94%) |

1 (2,94%) |

0 (0,00%) |

0 (0,00%) |

6 (17,64%) |

26 (76,47%) |

|

Producción n=84 |

34 (40,47%) |

16 (19,04%) |

2 (2,38%) |

21 (25,00%) |

2 (2,38%) |

9 (10,71%) |

|

Percepciones n=22 |

9 (40,90%) |

2 (9,09%) |

4 (18,18%) |

5 (22,72%) |

1 (4,54%) |

1 (4,54%) |

|

Negacionismo n=5 |

1 (20,00%) |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

4 (80,00%) |

|

Papel del periodismo n=11 |

1 (9,09%) |

6 (54,54%) |

0 (0,00%) |

1 (9,09%) |

0 (0,00%) |

3 (27,27%) |

|

Emociones n=7 |

1 (14,28%) |

0 (0,00%) |

1 (14,28%) |

1 (14,28%) |

1 (14,28%) |

3 (42,85%) |

|

Deepfakes n=5 |

1 (20,00%) |

0 (0,00%) |

0 (0,00%) |

1 (20,00%) |

0 (0,00%) |

3 (60,00%) |

|

Ciberseguridad n=2 |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

0 (0,00%) |

2 (100%) |

Fuente: elaboración propia

4. Discusión y conclusiones

Este estudio establece una completa cartografía de la agenda temática, los tipos de trabajo, las áreas de conocimiento, los países de procedencia y el impacto de la literatura científica sobre desinformación entre 2016 y 2020, el periodo de mayor atención investigadora hacia este fenómeno hasta la fecha. Las temáticas más frecuentes son (1) aquellas que abordan las soluciones para afrontar esta problemática y (2) los estudios experimentales sobre sesgos psicológicos e ideológicos en los procesos de recepción de los contenidos falsos. En cuanto a las soluciones, una amplia variedad de enfoques protagoniza los estudios en el periodo observado (se ha detectado un total de 12 aspectos diferentes desde los que enfrentar este desafío). El número de estudios que analizan las formas de confrontar las noticias falsas se ha incrementado notablemente desde 2016. Estos resultados muestran la preocupación que este problema suscita, así como la emergencia de la búsqueda de mecanismos para su contención. A la inversa, los estudios sobre sesgos cognitivos, muy prevalentes al inicio, han disminuido progresivamente desde 2016. Este decrecimiento no es obstáculo para colocar al campo de la psicología como una de las áreas desde las que mayor volumen de artículos se publican, confirmando estudios anteriores como el de Ha, Andreu-Pérez y Ray (2019). Estos trabajos desde el ámbito psicológico ofrecen un conocimiento muy valioso para analizar las diferencias en la percepción de los contenidos falsos y la información verídica. La mayoría de estos artículos analizan cómo los sesgos psicológicos e ideológicos se activan cuando los ciudadanos tienden a creer todo aquello que se alinea con su visión del mundo (Elías, 2021). Estos sesgos también actúan en los sujetos a la hora de creer contenidos falsos, incluso después de haber sido desmentidos por los verificadores (Chan et al., 2017). Procesos como el efecto contraproducente de las verificaciones y el razonamiento motivado (crear explicaciones alternativas para hacer compatible la realidad con los sesgos ideológicos) han sido empleados para explicar las resistencias hacia la información verificada (Cook, Lewandowsky y Ecker, 2017; Swire et al., 2017).

Sin embargo, ninguno de estos aspectos –soluciones y sesgos cognitivos– se encuentran entre los más citados. La temática de mayor impacto es la centrada en los patrones de propagación del contenido falso. En este ámbito, el estudio de Vosoughi, Roy y Aral (2018) es el que registra mayor número de citas relativas. Las definiciones de los conceptos clave vinculados con el fenómeno de la desinformación es la segunda categoría temática con mayor impacto. Estas definiciones se suelen abordar con la realización de trabajos ensayísticos, el tipo de artículo más publicado. De estos últimos datos se infiere que la desinformación -en su forma actual- es un objeto de estudio novedoso que aún necesita establecer unos límites conceptuales claros consensuados por una comunidad científica que en el último lustro ha protagonizado incesantes discusiones sobre los anclajes teóricos de este fenómeno.

Tras el campo de la psicología, las ciencias políticas y el análisis de las redes sociales son las disciplinas más salientes en cuanto al número de trabajos publicados. La utilización de estrategias desinformativas en procesos electorales y, en general, con fines políticos y la relevancia de las plataformas digitales en estas estrategias explican estos resultados. El elevado volumen de artículos sobre salud queda justificado por el aluvión de estudios sobre desinformación que la crisis sanitaria de la Covid-19 generó desde marzo de 2020. La diversidad de campos desde los que se ha abordado este fenómeno muestra su carácter multidimensional, que obliga a la colaboración entre expertos de diferentes disciplinas.

Otro aspecto relevante es la alta presencia de trabajos de tipo cuantitativo, sobre todo procedentes del ámbito anglosajón. Sería deseable, no obstante, desarrollar mayor número de investigaciones con metodologías mixtas (muy poco presentes en los estudios analizados), cuyas miradas cualitativas puedan conferir mayor profundidad y detalle a los resultados estadísticos obtenidos con métodos cuantitativos (Jankowski, 2018). Tampoco son especialmente frecuentes los trabajos de revisión de la literatura, a pesar de ser (tras los estudios cuantitativos no experimentales) los de mayor impacto.

Desde el punto de vista geográfico, nuestro estudio confirma el liderazgo de Estados Unidos en el estudio de esta problemática. Trabajos anteriores ya habían señalado la hegemonía de este país en el abordaje científico y académico de los contenidos falsos (Ha, Andreu-Pérez y Ray (2019). En realidad, este liderazgo del país norteamericano es extrapolable a todo el contexto anglosajón (Reino Unido, Canadá y Australia). Asimismo, Estados Unidos concentra los estudios de caso más frecuentes, enfocados en procesos políticos de agenda estadounidense, como las elecciones de 2016, el mandato de Donald Trump y las injerencias de Rusia en la política de aquel país. Este aspecto coincide con los resultados obtenidos por otros estudios, como el de Nieminen y Rapeli (2019).

Por otro lado, los cálculos mediante estadística inferencial determinan que el tipo de trabajo (aproximación metodológica) es la única variable que resulta relevante en su impacto. Ni el tema del estudio, ni el área de conocimiento desde el que se aborda, ni el país de realización de la investigación resultan factores determinantes.

Para finalizar, conviene reseñar algunos de los aspectos relacionados con la desinformación que aún no han recibido suficiente atención y que, por tanto, pueden erigirse como líneas de investigación a explorar para futuras aproximaciones a este fenómeno. En primer lugar, resulta llamativo el déficit de estudios sobre los aspectos jurídicos relacionados con el etiquetado y eliminación de los contenidos falsos y las fuentes desinformativas, tanto en las plataformas digitales como en otros espacios. También sorprende que, frente al predominio de los trabajos realizados desde el ámbito político, la otra gran motivación de la generación de contenidos falsos (las razones económicas) no adquieren la misma relevancia en este tipo de estudios. Sería interesante potenciar el abordaje de aspectos tan relevantes como la black PR –las revisiones y comentarios ficticios de productos y servicios disponibles online (Rodríguez-Fernández, 2021)– y, en general, el uso de la desinformación con fines reputacionales e intereses comerciales. Tampoco ha sido saliente el estudio de la desinformación realizada en formatos sonoros. La creciente audificación del consumo mediático hace especialmente interesante el análisis de los contenidos falsos que circulan mediante notas de voz en servicios de mensajería instantánea como WhatsApp o Telegram (García-Marín, 2021) o en medios como el podcast, en creciente expansión. Asimismo, se prevé que la investigación en otras áreas de emergente desarrollo tecnológico, como las deepfakes, o la utilización del blockchain como arma contra la desinformación (Tapscott y Tapscott 2016; Dickson, 2017) puedan adquirir mayor protagonismo en los próximos años.

5. Agradecimientos

Este artículo ha sido traducido al inglés por Brian O´Halloran.